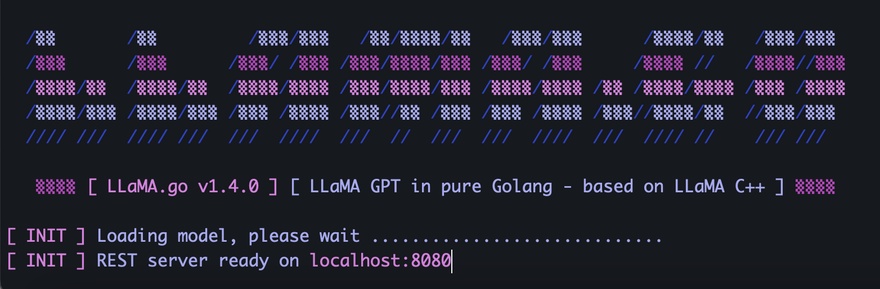

LLaMA.go 引入REST API以构建您自己的GPT服务

LLaMA.go 是一个重要的里程碑,内部有可扩展的服务器,允许使用REST API访问GPT模型,您可以将其集成到您的微服务网格中,或者构建自己的创业公司:)

他们团队已经发布了所有主要平台的预编译版本。此外,还可以免费使用转换后的7B和13B型号。

所有模型计算都在常规CPU/RAM上进行,因此根本不需要GPU访问。

目前还不支持模型量化,因此您需要至少32 Gb的RAM才能使用7B模型。

llama-go-v1.4.0-macos \

--model ~/models/llama-7b-fp32.bin \

--prompt "Why Golang is so popular?" \

- llama.go https://github.com/gotzmann/llama.go

- llama.cpp https://github.com/ggerganov/llama.cpp

0

See Also

- Gpt4all: 一个在基于LLaMa的约800k GPT-3.5-Turbo Generations上训练的聊天机器人

- Open Vision API 基于开源模型的开源计算机视觉API

- 亚马逊的产品广告API升级

- aiohttp.web+API-Hour

- 不禁惊叹twitter api的稳定

Nearby

- 上一篇 › Eruda - 适用于移动浏览器的开发工具

- 下一篇 › ChatGLM-6B:开源双语对话语言模型